Struts2历史高危漏洞分析系列:(二)

尽管现在struts2用的越来越少了,但对于漏洞研究人员来说,感兴趣的是漏洞的成因和漏洞的修复方式,因此还是有很大的学习价值的。毕竟Struts2作为一个很经典的MVC框架,无论对涉及到的框架知识,还是对过去多年出现的高危漏洞的原理进行学习,都会对之后学习和审计其他同类框架很有帮助。

Struts2历史高危漏洞分析系列:(一)

尽管现在struts2用的越来越少了,但对于漏洞研究人员来说,感兴趣的是漏洞的成因和漏洞的修复方式,因此还是有很大的学习价值的。毕竟Struts2作为一个很经典的MVC框架,无论对涉及到的框架知识,还是对过去多年出现的高危漏洞的原理进行学习,都会对之后学习和审计其他同类框架很有帮助。

一次简单的从web到域控

### 前言 菜鸡一次从web到域控的测试 ## 渗透开始 先在fofa上面寻找目标 语句:body="10.4.5 404 Not Found" && country="CN" && region="TW&quo...

免杀初探(三)

分享者才是最大的受益者

记一次实战过狗注入

在实际的渗透过程中,遇到目标存在waf的情况还是比较多的,本文记录了在一次实战中bypass安全狗进行注入的一些方法。

RMI Remote Object反序列化攻击

RMI通过序列化/反序列化传递对象信息,客户端发送的数据是否可控?服务端反序列化对象时是否有风险?本文将简单分析这些过程并说明其中的攻击点。

安卓学习思路方法总结(五)

分享者才是学习中最大的受益者

某CMS代码审计从前台注入到后台RCE

某CMS代码审计从前台SQL注入到后台RCE

业务逻辑越权之水平垂直越权

# 一、概念理解 ### 1.什么是越权越权: 越权访问(Broken Access Control,简称BAC)是我们在测试过程中遇到比较多的漏洞,该漏洞是指应用在检查授权时存在纰漏,使得攻击者在获得低权限用户...

从某开源靶场详细学习SQL注入的过程

开普勒安全PHP训练靶场的学习记录...

瞬态执行漏洞之Spectre V1篇(下)

在上一篇文章中,我们为读者介绍基于推测机制的瞬态执行漏洞的相关概念和原理进行了详细的介绍,在本文中,我们将深入分析Spectre V1的PoC源码。

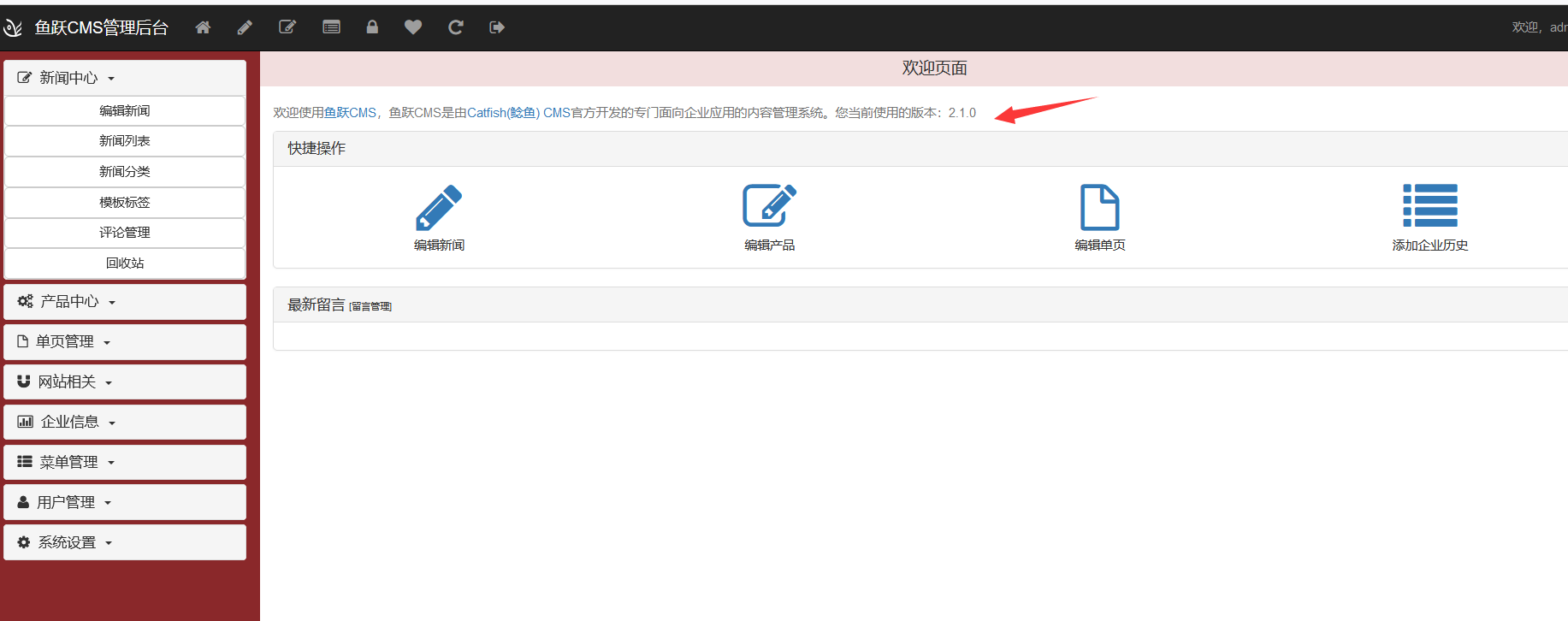

鱼跃CMS2.1.0插件处任意文件上传(删除)

一、源码地址以及版本 http://down.chinaz.com/soft/39353.htm [](https://shs3...

硬核黑客笔记 - 不够聪明的蓝牙锁

#### 0x00 前言 大家好, 我是Kevin2600. 最近设计了一套物理安防渗透课程, 在研发过程中遇到了一把蓝牙锁, 因其之前被大神Stawomir Jasek破解过, 本以为会是个简单的复现过程. 未曾想此蓝牙...

记一次文件上传

0x00 挖Src遇到的一个小tips 记录一下。 0x01 前台注册用户登录后台上传头像的一个点 正常上传jsp webshell + jpg 后缀 [

#1.介绍 mysql超长字符截断又名为“SQL-Column-Truncation”。 在mysql中的一个设置里有一个`sql_mode`选项,当`sql_mode`设置为default 时,即没有开启`STRICT_ALL_TABLES`选项或者`TRADITIO...

关于CVE-2021-21985的研究(含PoC)

# 写在前面 原本我是不喜欢写web的PoC的,本着能直接复制到burp里就复制到burp里,burp中慢慢调试可以绕waf可以慢慢调试,python还要开个代理去拦截数据包,还挺麻烦的。但是这个漏洞也太麻烦...